У чому полягає технічний SEO аудит сайту?

- 27/06/2020

- KR. Laboratories

- 438

Технічний аудит надзвичайно важливий і корисний процес, адже дає змогу в рази покращити швидкодію й ефективність будь-якого сайту. Пошукові системи неодмінно звертають увагу на технічні показники. Пропонуємо ознайомитися з алгоритмом технічного аудиту, який розробили наші SEO-спеціалісти.

Що таке технічний SEO аудит?

Технічний SEO аудит – це комплекс заходів щодо покращення усіх технічних параметрів, налаштунків і конфігурацій веб-сайту, включаючи систему управління (CMS) і веб-сервер. Основна робота спрямована на усунення перешкод в індексуванні сайту пошуковими системами.

В процесі аудиту, SEO фахівець проводить тестування усіх технічних вузлів сайту, щоби зафіксувати поточний стан та виявити помилки. По закінченню, формується технічне завдання (ТЗ) із повним списком робіт по проекту.

Зазвичай, після технічного SEO аудиту веб-сайт одразу починає набирати обертів, отримує органічний трафік, займає позиції у пошуковій видачі.

Сайт з технічними помилками, навіть якщо зовні непоганий, з великими складнощами просуватиметься в інтернеті. Тому ми рекомендуємо проводити технічний SEO аудит регулярно – раз на місяць, що дозволить постійно тримати сайт під контролем у задовільному технічному стані та позбавить будь-яких можливих технічних проблем в майбутньому.

З яких етапів складається технічний SEO аудит сайту?

1. Аналіз Backend-частини, сервера

Сервер на якому розміщений веб-сайт, тобто хостинг, має надзвичайно велике значення. Не налаштований належним чином сервер буде постійно тормозити і шкодити SEO просуванню.

Ми перш за все уважно перевіряємо коди відповідей сервера, такі як: 404, 500, 301. Вивчаємо статистику та збираємо логи, аналізуємо та оптимізуємо HTTP-заголовки, перевіряємо IP-адресу сервера та сайти, які розташовані на ній, вмикаємо та налаштовуємо кешування, змінюємо деякі налаштування в самій хостинг-панелі (тюнінг cPanel, DirectAdmin, ISPmanager, VestaCP, CyberPanel).

Складових успішного функціонування веб-сервера чимало. Наприклад, застаріла версія або неправильне налаштування PHP. Бували випадки, коли власникам сайту доводилось змінити хостинг (перенос сайту на інший сервер) як відразу зникала більша частина помилок і труднощів.

2. Аналіз системних файлів, конфігурації

Аналіз системних файлів допоміг викрити не одну проблему. htaccess, robors, sitemap – це найважливіші системні файли, розміщені у кореневій директорії сайту, які визначають його конфігурацію та функціонування. Без них жоден сайт не буде працювати, а тому необхідно з відповідальністю поставитися до їх налаштування.

- htaccess – здійснює зв’язок сайту з Apache сервером, конфігуратор технічних вузлів, керує кешуванням, здійснює редиректи і так далі.

- robots.txt – являє собою набір правил для пошуковиків, допомагає уникнути дублів сторінок, заблокувати доступ пошукових ботів до конфіденційних, приватних розділів/файлів/папок сайту.

- sitemap.xml – містить список усіх сторінок, доступних для індексування пошуковими роботами, транспортує ваш сайт, так би мовити, у пошук.

Усі ці файли є дуже важливими і їх правильна та детальна оптимізація гарантує успіх.

3. Аналіз структури сайту

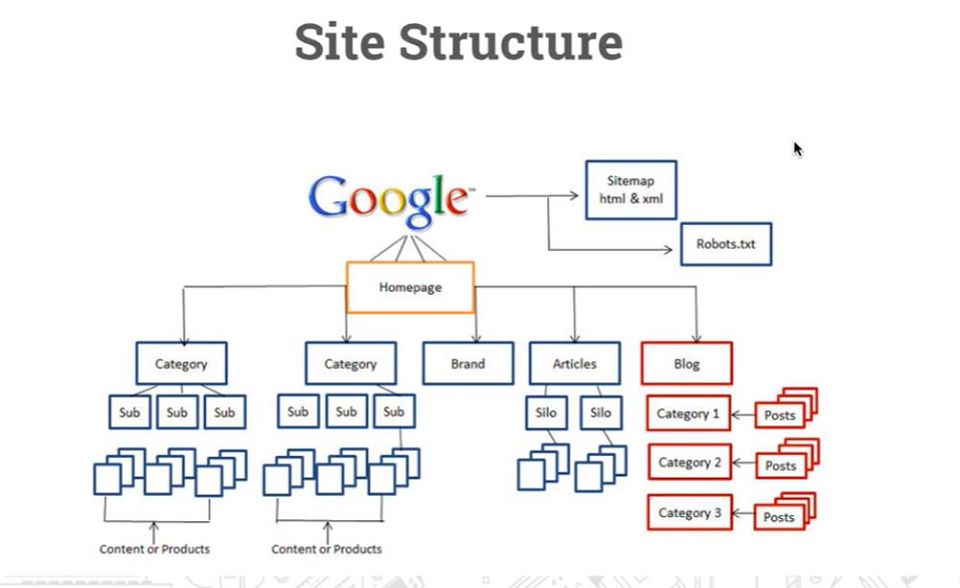

Являє собою парсинг усіх розділів, категорій, підкатегорій, усіх сторінок та окремих записів сайту для побудови ієрархічного дерева. Це допоможе ретельно проаналізувати існуючу структуру, виявити помилки та внести всі необхідні зміни.

Структура сайту відіграє дуже велику роль у індексуванні пошуковими роботами та подальшому просуванні веб-сайту. Вона має бути чіткою та продуманою, щоби пошуковик міг зрозуміти та проіндексувати. Структура не має бути заплутаною – це буде шкодити та зведе на нівець будь-яке SEO просування, навіть якщо у сайту привабливі верстка чи дизайн.

Насправді, ми дуже часто спостерігаємо таке явище, коли сайт успішно розробляється і запускається, але у нього немає чіткої структури. Власник про це просто не подумав, вважаючи що не гратиме жодної ролі і пізніше якось переробиться. Для того, щоби убезпечити себе від майбутніх проблем, потрібно обов’язково ретельно усе продумати, наприклад намалювати макет або створити мапу у MindManager, порадитись зі своїми колегами або звернутись до нас – ми спроектуємо максимально правильну SEO-структуру сайту, базуючись на факторах пошукових систем.

Що ми розуміємо під висловом “чітка структура”? Це структура, у якій користувачу зручно орієнтуватися, легко знаходити інформацію, а головне бот не заплутається у такій структурі.

Основні помилки, коли порушується послідовність Розділ -> Категорія -> Підкатегорія -> Запис та Головна -> Сторінка. Часто іде усе вперемішку, розділи копіюються, дублюються категорії разом із тегами, у такому хаосі краулер, на основі свого алгоритму, буде низько ранжувати ваш сайт, тому що не зрозуміє. Наші спеціалісти допоможуть ретельно змоделювати будь-яку структуру майбутнього сайту. Радимо не спішити і звернутися до експертів, щоб потім не шкодувати за помилки та витрачений час.

4. Аналіз веб-коду

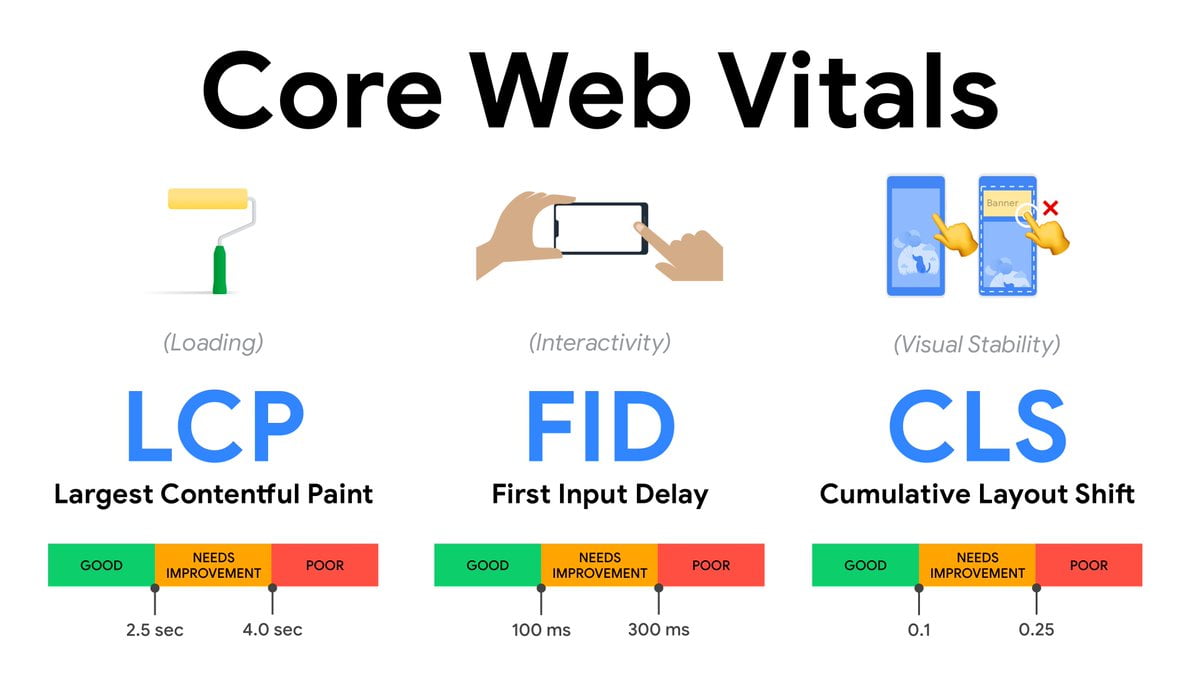

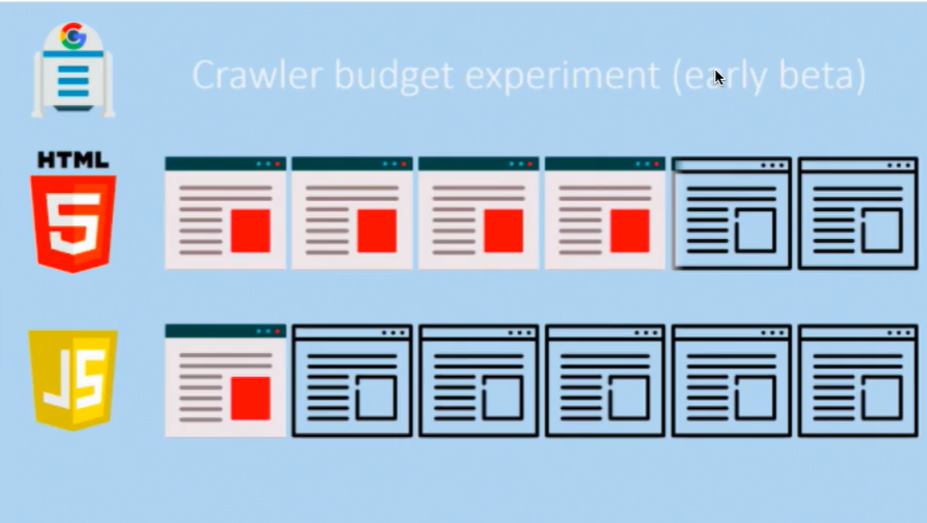

Як ми вже писали, веб-сторінки повинні швидко завантажуватися та бути завжди доступними для пошуковиків. Сторінки перенавантажені веб-кодом, CSS-стилями чи JS-скриптами, переадресаціями – не зможуть нормально індексуватись. Сучасні пошуковики вимагають, щоби сторінки були легкими і завантажувалися за лічені секунди на будь-яких пристроях. Google був створений новий алгоритм перевірки під назвою Core Web Vitals, який буде сканувати швидкодію та на цій основі відповідно ранжувати вниз або вгору.

Отже, ми перевіряємо ретельно весь веб-код сайту, виявляємо у ньому зайвий чи шкідливий код, об’єднюємо його і мінімізуємо частини, зменшуючи кількість переадресацій, усуваючи зациклення, роблячи веб-сторінки гнучкими та компактними, збільшуючи швидкість завантаження.

Часто помилки крилися у засміченому різними скриптами веб-коді сайту, який блокував коректному завантаженню та відображенню контенту. Адже будь-який сайт, перед тим як потрапити у SERP (пошукову стрічку) має пройти процесс краулінгу та індексації, які передують ранкінгу, тобто ранжуванню. Якщо краулер не просканує сайт, тоді він ніколи не потрапить до індексу і не відобразиться у пошуковій видачі.

Щоб код відповідав усім існуючим стандартам, ми у своїй роботі використовуємо програмні засоби, наприклад W3C HTML Валідатори, які працюють на базі Всесвітнього Консорціуму Мережі Інтернет.

5. Аналіз мета-тегів

Завданням будь-якого технічного аудиту є також виявлення хибних або не введених чи частково введених мета-тегів сторінок, до яких належать: Title, H1-H2, Description, Alt. Саме вони першими передають так-звану мета-інформацію у пошукові системи, які на основі отриманих даних присвоюють їм той чи інший ранкінг. Тому усі ці теги мають бути заповнені належним чином і не повторюватися. Дублі сторінок впливають на сайт не менше, ніж інші технічні помилки. Вони можуть суттєво підпортити ситуацію будь-якому сайту, якщо їх вчасно не виявити та ліквідувати.

У деяких випадках неможливо повністю знищити дублі (іноді динамічно генеруються), тому поширеною практикою є закривати їх від пошуковиків з допомогою відповідної директиви, або ж вказувати атрибути канонічних сторінок.

Також важливо налаштувати усі редиректи, переважно це 301-і редиректи які склеюють так-звані “зеркала” домену, наприклад: з htttp на https, з www на без www, без слеша на слеш / (або навпаки) тощо. Сайт повинен бути доступним тільки за єдиним доменом. Контент у жодному випадку не повинен дублюватися.

Повернімось до мета-тегів. Вони не повинні повторюватися та містити актуальні, релевантні дані, які відповідають змісту сторінки. У пошуку дублів ми користуємося такими автоматизованими програмними засобами як Seo Screaming Frog, Semparser, Xenu та Netpeak Spider. Завдяки їм, ми можемо просканувати і проаналізувати будь-який сайт, навіть якщо у нього сотні тисяч сторінок.

6. Аналіз CMS

Комплексний технічний SEO аудит неможливий без аналізу та перевірки продуктивності та працездатності системи управління (CMS), яка керує сайтом. Часто цю функцію виконує відповідний фреймворк, але найчастіше застосовуються звичні для користувача, безкоштовні системи управління WordPress або Joomlа, рідше – Bitrix, Drupal, MODx, Majento та інші.

Не вірно налаштована СМS часто є головним джерелом технічних помилок сайту. Тому, ми перевіряємо усі логи, конфігурацію, встановлені модулі і плагіни, перевіряємо темплейти (шаблони) та оновлення до всіх компонентів CMS-системи.

Додатково інсталюємо розширення, котрі будуть прискорювати та захищати CMS-систему від різних збоїв та помилок, а у випадку помилки збоку користувача – буде можливість швидко зробити відкат до попередніх змін, використовуючи резервну копію (baсkup & recovery).

7. Аналіз безпеки сайту

Ще одна річ, на що не звертають увагу власники сайтів – це безпека. За нашими спостереженнями, майже 75% сайтів є вразливими до хакерських атак. Думати, що ваш сайт нікому не потрібен – не вихід. Адже випадки крадіжки веб-сайтів почастішали.

Ось те, що ми перевіряємо:

- Перевірка вразливості web-сервера і мережевої інфраструктури

- Перевірка вразливості CMS і веб-коду

- Перевірка на вразливості за списком OWASP Top 10

8. Аналіз юзабіліті, адаптивності

І на закінчення: перевіряємо як сайт відображається на різних пристроях та дисплеях (мобільні, планшети, ноутбуки, ПК), браузерах (Safari, Chrome, Mozilla, Opera, IE). Користуючись панелями веб-майстрів, виявляємо баги верстки шаблону та інші поширені помилки й складаємо технічне завдання на їх усунення.

Підписуйтесь на новини та отримуйте нові публікації на свою електронну пошту!